Il PSI ottimizzato serve davvero al nostro sito? E se poi lo facciamo ed il ranking non migliora, abbiamo perso tempo?

Non mi dilungherò su come ottimizzare il PSI, tanto più che ne ho già parlato in un articolo precedente. Quello che mi interessa focalizzare, dopo averne discusso con un collega giusto ieri, è capire se sia davvero un fattore di ranking a cui qualsiasi sito debba dare importanza o meno. Per farlo, partirò da un classico contro-esempio che spesso viene indicato come, probabilmente, il motivo più grande per fregarsene del PageSpeed Insights.

Prima pero’, faccio un breve recap sul tema.

PSI non è la “velocità del sito”

Stando a quello che sappiamo, il PSI di Google NON è una semplice misura di “velocità del sito”, ma si basa sulla combinazione di sei metriche che considerano le tempistiche intermedie di caricamento e la UX della pagina:

- First Contentful Paint

-

Speed Index

-

Largest Contentful Paint

-

Time to Interactive

-

Total Blocking Time

-

Cumulative Layout Shift

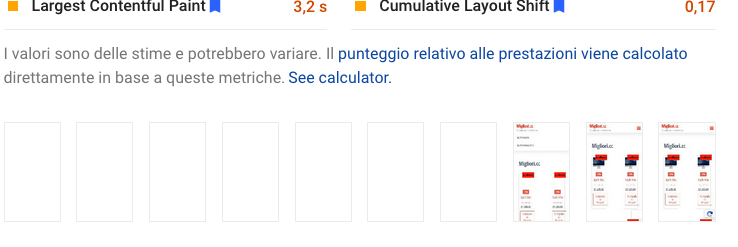

Il First Contentful Paint o FCP, ad esempio, misura (relativamente al tempo impiegato per fare la stessa cosa su un campione esterno di siti) il tempo necessario perchè il DOM (l’oggetto gerarchico associato ad una qualsiasi pagina web, la cui complessità e corposità rappresenta buona parte dell’ottimizzazione) mostri almeno una parte della pagina. Lo Speed Index, invece, rappresenta il tempo necessario per renderizzare i singoli frame che compongono il caricamento (vedi figura successiva), il Largest Contentful Paint misura il tempo di completamento del caricamento, mentre il Time to Interactive è una misura di UX che verifica approssimativamente quando l’utente può interagire con la pagina perchè il DOM è pronto per l’interazione (cliccare un bottone, aprire un menù, e così via).

Sono tutte stime variabili (e probabilmente approssimate), e Google ci tiene a specificare la cosa in più contesti quasi a sottolineare che il punteggio potrebbe anche cambiare tra misurazioni successive, anche senza cambiare nulla nel proprio sito web: il che sembra assurdo, ma considerando la natura delle metriche in questione ha un senso. Senza dettagliare ulteriormente la questione, bisogna sapere che esiste un tool per pre-calcolare il PSI e verificare come venga ottenuto il punteggio finale, cosa che potrebbe essere utile quando si deve decidere cosa ottimizzare e che cosa, eventualmente, sacrificare nel proprio sito.

Il punto che cercheremo di capire è se davvero valga sempre la pena farlo, a questo punto. In breve, la risposta è no, anche se solitamente si arriva a questa conclusione per i motivi sbagliati – che sembra una questione di poco conto, ma non lo è.

Siti grossi e famosi hanno punteggio PageSpeed Insights basso, “quindi”… non mi serve!

Credo che sia un classico esempio di conclusioni sbagliate che non fanno, nel 90% dei casi, che confermare un bias di conferma (nel senso che volevo arrivare alla conclusione che non mi va di ottimizzarlo perchè è lungo e difficile, per cui non lo avrei fatto comunque), per quanto ci sia un fondo di verità inoppugnabile.

In parte è vero: siti web molto ben posizionati su Google e con metriche SEO stellari, alla prova dei fatti, si scoprono avere punteggi PSI estremamente bassi, e questo (secondo molti addetti ai lavori) sarebbe un contro-senso ed un contro-argomento a favore del fatto che “non serva a nulla” ottimizzarlo. La questione pero’, secondo me, è posta male: il fatto che quei siti giganti abbiano metriche PSI basse (ad esempio ansa.it, ma ne potrei citare molti altri) e siano comunque posizionati bene su Google per varie ricerche vuol dire, al massimo, che il PSI non è un fattore penalizzante (quasi sicuramente, per essere sicuri di quello che scriviamo), ma questo non significa che non possa essere un fattore migliorativo. Nella SEO del resto raramente si procede con le certezze, soprattutto quando la competizione è alta, per cui quel discorso iniziale rischia di diventare contro-producente: le cose vanno viste sempre caso per caso, sito per sito, non esistono ricette assolute e universali (purtroppo).

Il discorso vale anche per via del termine di paragone che si va a prendere, perchè – al limite – dovremmo confrontare il PSI dei nostri competitor diretti, non prendere i siti top che comunque problemi di visibilità non ne hanno e vivono, alla prova dei fatti, anche di brand forti. Nulla di strano, quindi, che siti di grosse multinazionali non abbiano il PageSpeed Insights ottimizzato e siano comunque primi sui motori: semmai, è strano (anche se non necessariamente sbagliato!) che non provino ad usarlo come fattore di ranking. Anche perchè non è questione, secondo me, di “dare il contentino” a Google: è questione che migliorare quelle metriche (se ci riusciamo, e se possibile) porta benefici effettivi, perchè i siti ottimizzati con 90/100 e oltre sono effettivamente più veloci e funzionali.

Quindi: non è una metrica probabilmente così vitale come potrebbe sembrare, ma sono convinto che sia una risorsa da sfruttare – ammesso ovviamente che l’azienda abbia la sensibilità necessaria ad accogliere un’istanza del genere. Anche perchè è uno dei pochissimi fattori di ranking pubblici e ottimamente documentati, che si possono migliorare grazie ad un’attività di SEO audit lato CSS e JS.

Ottimizzare il PSI è mediamente piuttosto complesso, alla prova dei fatti, e spesso diventa problematico sui theme non open source e su quelli premium, i quali spesso puntano su grafiche mirabolanti (e a volte addirittura poco funzionali) e raramente sono ottimizzati lato DOM come avviene, ad esempio, per i siti più classici ed essenziali. Minificare, comprimere, ridurre il numero di chiamate (anche se con HTTP/2 questo, a breve, non dovrebbe nemmeno servire più), ma non solo: ridurre le dipendenze tra codice e/o evitare bug di doppia minificazione sul CSS e sul JS con i CMS moderni, che sputano fuori HTML sempre più contorti e difficili da modificare, è senza dubbio un’impresa. Ma è un’impresa che fa parte delle attività SEO moderne, almeno nella misura in cui i dati di cui disponiamo lo confermano.

Posso accettare che per molti non sia una priorità perchè magari, ad esempio, ci sono aziende che investono quasi tutto in social e non gli interessa la SEO. Ma anche in considerazione dei web signals (segnali web essenziali) che sono stati integrati nella Search Console, magari se c’è qualche barretta rossa o gialla di troppo, ecco… un pensiero ce lo farei.

Resta un dilemma di fondo: e se poi il sito non si posiziona lo stesso dopo averlo ottimizzato lato PSI? Diciamo che la modifica fa bene lo stesso, perchè comunque i siti veloci performano comunque meglio lato utente – per non dire che, a volte, convertono pure qualcosa in più: quando è stata l’ultima volta che avete visto Amazon.it offline, ad esempio?

La questione è molto complessa: nel frattempo, pero’, bisognerebbe smetterla di pensare alla SEO come una serie di manopole da manipolare a piacimento, andrebbe forse fatta in modo più elastico, funzionale alle nostre attività imprenditoriali di ogni giorno di conversione, di lead e via dicendo.

A qualcuno potrebbe servire di più, e ad altri di meno: sta a noi deciderlo volta per volta. E la nostra decisione farà la differenza nel lungo periodo.